Archivo de la categoría: Física

Participaciones en el XLI Carnaval de la Física

A continuación tenéis la lista de participaciones que están llegando al XLI Carnaval de la Física, cuya temática en esta ocasión es las misteriosas y polémicas: Materia Oscura y Energía Oscura, pero recordad que no es un requisitos que se trate de ese tema así que estad atentos porque habrá mucha variedad en los aportes.

Este Carnaval recién empieza pero ya llegan algunos aportes, estaré actualizando esta entrada diariamente así que estad atentos y ¡No os perdáis ninguno!

Este Carnaval recién empieza pero ya llegan algunos aportes, estaré actualizando esta entrada diariamente así que estad atentos y ¡No os perdáis ninguno!

El día 28 de Abril se publicará la lista definitiva.

1. Aquí abajo todos flotan…

3. Stern y Gerlach – El experimento que cambio el curso de la Física

@altatoron nos lleva unos cuantos años hacia el pasado, a conocer la historia de un par de físicos que lograron cambiar el curso de la Física gracias a su ferviente perseverancia, un poco de suerte y un par de cigarrillos baratos. Adentraros en la historia de Otto Stern y Walter Gerlach dos físicos con mucha convicción y suerte, juntos lograron llevar a cabo un experimento que literalmente cambio el curso de la Física y la encausaron a lo que es ahora, el experimento fue la primera verificación experimental de las predicciones de la teoría cuántica. Con él, la física cuántica pasó, de ser un conjunto de recetas que trataba de explicar el extraño mundo microscópico, a ser una verdadera teoría física, capaz de hacer predicciones que eran verificadas experimentalmente.

4. Explicando la materia oscura a un estudiante de derecho (o a cualquiera que no sea astrofísico)

@astrosalpimien nos explica en esta oportunidad en que consiste la materia oscura, tomando como base la rotación de las galaxias espirales que de hecho fueron las primeras en el que se detectó (o mejor dicho, no se detectó) la materia oscura. Con palabras sencillas, un vídeo de Sheldon Cooper y con un mínimo de detalles técnicos seguramente comprenderás fácilmente que es la materia oscura y como es que sabemos que esta allá fuera aunque no podamos verla. Como el titulo lo indica no tienes que ser un físico o un astrofísico para poder comprenderlos… Así que ¿Qué estáis esperando?… Leed, leed y leed…!!

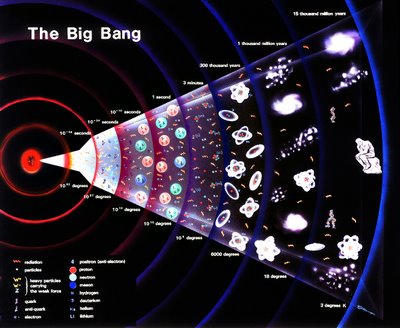

5. El Principio del Universo

@Monzonete nos presenta un vídeo de aproximadamente 3 minutos de duración en el que se nos explica clara y muy sencillamente que paso después del Big Bang, el científico realizador del vídeo es Tom Whyntie. Realmente vale la pena verlo.

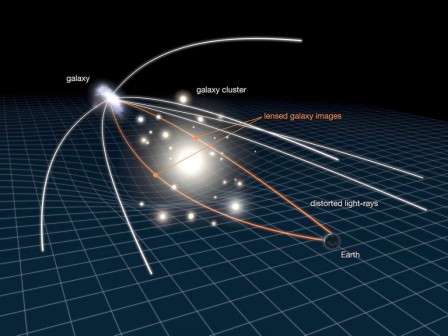

6. Explicando la materia oscura… a cualquiera que no sea astrofísico II: Materia oscura en el universo

@Astrosalpimien se hace presente una vez mas en el Carnaval y en esta ocasión nos presenta la segunda parte de su muy interesante primera entrada: «Explicando la materia oscura… a cualquiera que no sea astrofísico». En su entrada nos da un recorrido por fenómenos astrofísicos en los que es necesario introducir un término adicional de materia oscura a la materia ordinaria para poderlos explicar, incluyendo las Galaxias Elípticas, las Galaxias Espirales, los Cúmulos de Galaxias, las Lentes Gravitatorias, etc. Si no eres astrofísico y te gusta el espacio, esta es la entrada que tienes que leer…

7. La central nuclear y cómo tener una en casa

@Roskiencia nos presenta una excelente entrada sobre las Centrales Nucleares y como es que funcionan, la Fisión Nuclear y ademas nos enseña que construir nuestra propia Central Nuclear no es nada difícil, y la podemos tener hasta en la sala de nuestra casa… Yo no se que vais a hacer vosotros, pero yo empiezo a buscar un poco de Uranio 235.

8. El principio de Fermat, los extraterrestres y el pelo en el pechete

@Cuantozombi y su increíble originalidad ha echo de las suyas otra vez, esta vez con la ayuda de Fermat, donde nos explica un extracto del relato La historia de tu vida, de Ted Chiang… Una divertidisíma explicación que sin lugar a dudas simplemente os encantará…

9. Una breve historia de casi todo

Mi buen amigo @CuantosyCuerdas estrena sección en su Blog con una muy buena reseña sobre un libro que todos deberíamos leer: «Una breve historia de casi todo», Bill Bryson (el autor del libro) nos da un recorrido científico que empieza desde el principio del Universo mismo hasta nuestros días, un libro que simplemente te cautivara… Pero si aun así dudáis de mi, echadle un vistazo a la completísima reseña que @CuantosyCuerdas nos presenta, no os arrepentiréis, os lo aseguro…

10. Cine y bichos: Erin Brockovich

@ManoloSanchezA nos explica en su blog que es exactamente el Cromo Hexavalente y sus utilidades practicas, ademas de servir como tema central en una reconocida película biográfica llamada «Erin Brockovich»… Si os gusta la Física y la Química debéis leerla…

.jpg)

11. Superfluidez y condensación de Bose – Einstein

@AdrianMaciaRey nos presenta en esta ocasión un tema que helaría a cualquiera…. Literalmente… Como protagonistas tenemos los gases a temperaturas extremadamente bajas, cercanas al cero absoluto y de alguno de los extraordinarios fenómenos que se dan en estas condiciones extremas. Y como nos sugiere Adrian coged un abrigo antes de partir…

12. La materia y la energía oscura, una primera aproximación

Araceli Giménez Lorente en su Blog HIGH ABILITY DIMENSION nos habla de forma muy concreta acerca de la que posiblemente seria la materia y energía oscura… Ademas, al final podéis apreciar un muy buen documental sobre el tema…

13. Humor Físico III, Ángeles en un alfiler

Y Araceli Giménez Lorente nos regala una verdadera joya en otro blog, en esta ocasión en «El mundo de las Ideas», me ha encantado y os la recomiendo encarecidamente… Un ejemplo de que nunca debemos dejar que nos «enseñen» a pensar…

Una Estrella de la Muerte sin Ciencia Ficción

La Estrella de la Muerte es un arma colosal, del tamaño de una luna entera. Con un disparo a quemarropa contra el indefenso planeta Alderaan, patria de la princesa Leia, la Estrella de la Muerte lo incinera y provoca una titánica explosión que lanza restos planetarios a través del sistema solar.

El gemido angustioso de mil millones de almas crea una perturbación en la Fuerza que se siente en toda la galaxia. Pero ¿es realmente posible el arma Estrella de la Muerte de la saga La guerra de las galaxias? ¿Podría un arma semejante concentrar una batería de cañones láser para vaporizar un planeta entero? ¿Qué pasa con los famosos sables de luz que llevan Luke Skywalker y Darth Vader, que pueden cortar acero reforzado pese a que están hechos de haces luminosos? ¿Son las pistolas de rayos, como los fáseres en Star Trek, armas viables para futuras generaciones de soldados y oficiales de la ley?

Diagrama esquemático de la Estrella de la Muerte

Millones de espectadores que vieron La guerra de las galaxias quedaron estupefactos ante estos asombrosos y originales efectos especiales. Algunos críticos, no obstante, los despreciaron; dijeron que todo eso era pura diversión pero evidentemente imposible. Las pistolas de rayos que destruyen planetas del tamaño de la Luna son imposibles, como lo son las espadas hechas de haces luminosos solidificados. Esta vez, el maestro de los efectos especiales, había ido demasiado lejos.

Aunque quizá sea difícil de creer, el hecho es que no hay ningún límite físico a la cantidad de energía bruta que puede acumularse en un haz de luz. No hay ninguna ley de la física que impida la creación de una Estrella de la Muerte o de sables luminosos. De hecho, haces de radiación gamma que destruyen planetas existen en la naturaleza. La titánica ráfaga de radiación procedente de un lejano estallido de rayos gamma en el espacio profundo crea una explosión solo superada por el

propio Big Bang. Cualquier planeta que desafortunadamente esté dentro de la diana de un estallido de rayos gamma será incinerado o reducido a pedazos o quizás menos que pedazos…

Ilustración de un estallido de rayos gamma.

LAS ARMAS DE RAYOS A TRAVÉS DE LA HISTORIA

El sueño de dominar haces de energía no es realmente nuevo, sino que está enraizado en la mitología y el folclore antiguos. El dios griego Zeus era famoso por arrojar rayos sobre los mortales. El dios nórdico Thor tenía un martillo mágico, Mjolnir, que podía desprender rayos, mientras que el dios hindú Indra era conocido por disparar haces de energía desde una lanza mágica.

Pintura que ilustra al dios Zeus y el poder del rayo.

La idea de utilizar rayos como un arma práctica empezó probablemente con la obra del gran matemático griego Arquímedes, quizá el científico más importante de la Antigüedad, que descubrió una cruda versión del cálculo infinitesimal hace dos mil años, antes de Newton y Leibniz. Arquímedes sirvió en la defensa del reino de Siracusa en una batalla legendaria contra las fuerzas del general romano Marcelo durante la segunda guerra púnica, en el 214 a.C. Se dice que creó grandes baterías de reflectores solares que concentraban los rayos del Sol en las velas de las naves enemigas y las incendiaba. (Todavía hoy los científicos discuten sobre si esto era un arma de rayos practicable; varios equipos de científicos han tratado de repetir esta hazaña con diferentes resultados).

Funcionamiento de la estrategia de Arquímedes para derrotar a los romanos.

Las pistolas de rayos irrumpen en el escenario de la ciencia ficción en 1889 con el clásico de H. G. Wells La guerra de los mundos, en el que alienígenas procedentes de Marte devastan ciudades enteras disparando haces de energía térmica desde armas montadas en trípodes. Durante la Segunda Guerra Mundial, los nazis, siempre dispuestos a explotar los últimos avances en tecnología para conquistar el mundo, experimentaron con varias formas de pistolas de rayos, incluido un aparato sónico, basado en espejos parabólicos, que podía concentrar intensos haces de sonido. Las armas creadas a partir de haces luminosos concentrados pasaron a formar parte del imaginario colectivo con la película de James Bond Goldfinger, el primer film de Hollywood en el que aparecía un láser. (El legendario espía británico estaba tendido y sujeto con correas en una mesa metálica mientras un potente haz láser que avanzaba lentamente entre sus piernas iba fundiendo la mesa y amenazaba con cortarle por la mitad).

James Bond a punto de ser cortado a la mitad por un rayo láser.

Al principio, los físicos se mofaron de la idea de las pistolas de rayos que aparecían en la novela de Wells porque violaban las leyes de la óptica. De acuerdo con las ecuaciones de Maxwell, la luz que vemos a nuestro alrededor se dispersa rápidamente y es incoherente (es decir, es una mezcla de ondas de diferentes frecuencias y fases). En otro tiempo se pensaba que haces de luz uniformes, coherentes y concentrados, como los que encontramos en los haces láser, eran imposibles.

LA REVOLUCIÓN CUÁNTICA

Todo esto cambió con la llegada de la teoría cuántica. A comienzos del siglo XX estaba claro que aunque las leyes de Newton y las ecuaciones de Maxwell eran espectacularmente acertadas para explicar el movimiento de los planetas y el comportamiento de la luz, no podían explicar toda una clase de fenómenos. Fallaban estrepitosamente para explicar por qué los materiales conducen la electricidad, por qué los metales se funden a ciertas temperaturas, por qué los gases emiten luz cuando son calentados, por qué ciertas sustancias se hacen superconductoras a bajas temperaturas —todo lo cual requiere una comprensión de la dinámica interna de los átomos—. Había llegado el tiempo para una revolución. Doscientos cincuenta años de física newtoniana estaban a punto de ser superados, lo que anunciaba el nacimiento de una nueva física.

En 1900 Max Planck, en Alemania, propuso que la energía no era continua, como pensaba Newton, sino que se daba en pequeños paquetes discretos llamados «cuantos». Tiempo después, en 1905, Einstein postuló que la luz consistía en estos minúsculos paquetes discretos, más tarde bautizados como «fotones». Con esta idea poderosa pero simple, Einstein fue capaz de explicar el efecto fotoeléctrico, por qué los metales que reciben luz emiten electrones.

Hoy, el efecto fotoeléctrico y el fotón forman la base de la televisión, los láseres, las células solares y buena parte de la electrónica moderna. La teoría de Einstein del fotón era tan revolucionaria que incluso Max Planck, normalmente un gran defensor de Einstein, no podía creerla al principio. Al escribir sobre Einstein, Planck dijo «que a veces pueda haber errado el blanco […] como por ejemplo, en su hipótesis de los cuantos de luz, no puede realmente alegarse en su contra».

Y no podía faltar Einstein…

En 1913 el físico danés Niels Bohr nos dio una imagen del átomo completamente nueva, una imagen que se parecía a un sistema solar en miniatura. Pero a diferencia de lo que ocurre en un sistema solar en el espacio exterior, los electrones solo pueden moverse en órbitas o capas discretas alrededor del núcleo. Cuando los electrones «saltaban» de una capa a otra capa más interna con menor energía, emitían un fotón de energía. Cuando un electrón absorbía un fotón de energía discreta, «saltaba» a una capa más grande con más energía. Una teoría del átomo casi completa surgió en 1925 con la llegada de la mecánica cuántica y la obra revolucionaria de Erwin Schródinger, Werner Heisenberg y muchos otros. Según la teoría cuántica, el electrón era una partícula, pero tenía una onda asociada con ella, lo que le daba propiedades de partícula y de onda a la vez. La onda obedecía a una ecuación, llamada ecuación de onda de Schródinger, que permitía calcular las propiedades de los átomos, incluidos todos los «saltos» postulados por Bohr.

Antes de 1925 los átomos todavía eran considerados objetos misteriosos que muchos, como el filósofo Ernst Mach, creían que no podían existir. Después de 1925 se podía observar realmente la dinámica del átomo y predecir realmente sus propiedades. Esto significaba que si tuviéramos un ordenador suficientemente grande, podríamos derivar las propiedades de los elementos químicos a partir de las leyes de la teoría cuántica. De la misma forma que los físicos newtonianos podrían calcular los movimientos de todos los cuerpos celestes en el universo si tuvieran una máquina de calcular suficientemente grande, los físicos cuánticos afirmaban que en teoría se podrían calcular todas las propiedades de los elementos químicos del universo. Si tuviéramos un ordenador suficientemente grande, también podríamos escribir la función de onda de un ser humano entero.

MÁSERES Y LÁSERES

En 1953 el profesor Charles Townes de la Universidad de California en Berkeley y sus colegas produjeron la primera fuente de radiación coherente en forma de microondas. Fue bautizada como «máser» (las siglas de amplificación de microondas mediante emisión estimulada de radiación). El y los físicos rusos Nikolái Basov y Alexander Projorov ganarían el premio Nobel en 1964. Sus resultados fueron extendidos pronto a la luz visible, lo que dio nacimiento al láser. (Un fáser, sin embargo, es un aparato de ficción popularizado en Star Trek).

El primer Máser.

En un láser se empieza con un medio especial que transmitirá el haz láser, tal como un gas, un cristal o un diodo especial. Luego se bombea energía en este medio desde el exterior, en forma de electricidad, radio, luz o una reacción química. Este repentino flujo de energía se transmite a los átomos del medio, de modo que los electrones absorben la energía y saltan a las capas electrónicas más externas. En este estado excitado el medio es inestable.

Si se envía entonces un haz de luz a través del medio, los fotones incidirán en cada átomo y harán que se desexciten repentinamente, caigan a un nivel inferior y liberen más fotones en el proceso. Esto produce a su vez aún más electrones que liberan fotones, y por último se crea una cascada de átomos que colapsan, lo que libera repentinamente en el haz billones y billones de fotones.

La clave es que, para ciertas sustancias, cuando se produce esta avalancha todos los fotones están vibrando al unísono, es decir, son coherentes. (Imaginemos una hilera de fichas de dominó. Las fichas de dominó en su estado más bajo están tumbadas sobre la mesa. Las fichas en su estado bombeado de alta energía permanecen verticales, similares a los átomos excitados por bombeo en el medio. Si empujamos una ficha, podemos desencadenar un repentino colapso de toda esta energía de una vez, igual que en un haz láser).

Solo ciertos materiales «lasearán», es decir, solo en materiales especiales sucede que cuando un fotón incide en un átomo bombeado se emitirá otro fotón que es coherente con el fotón original. Como resultado de tal coherencia, en este diluvio de fotones todos los fotones vibran al unísono, creando un haz láser fino como un pincel. (Contrariamente al mito, el haz láser no permanece siempre fino como un pincel. Un haz láser dirigido a la Luna, por ejemplo, se expandirá poco a poco hasta que cree una mancha de algunos kilómetros de diámetro). Un sencillo láser de gas consiste en un tubo con helio y neón. Cuando se envía electricidad a través del tubo, los átomos se energizan. Entonces, si la energía se libera de golpe, se produce un haz de luz coherente. El haz se amplifica colocando espejos en cada extremo del tubo, de modo que el haz rebota de un lado a otro entre ambos. Un espejo es completamente opaco, pero el otro permite que escape una pequeña cantidad de energía en cada paso, de manera que sale un haz luminoso por dicho extremo.

Esquema de un máser de hidrógeno.

Hoy día encontramos láseres en casi todas partes, desde las cajas registradoras de los supermercados a los ordenadores modernos, pasando por los cables de fibra óptica que conectan con internet, las impresoras láser y los reproductores de CD. También se utilizan en cirugía ocular, o para eliminar tatuajes, e incluso en salones de belleza. En 2004 se vendieron en todo el mundo láseres por valor de más de 5.400 millones de dólares.

TIPOS DE LÁSERES

Cada día se descubren nuevos láseres a medida que se encuentran nuevos materiales que pueden «lasear», y a medida que se descubren nuevas maneras de bombear energía al medio.

La pregunta es: ¿son algunas de estas técnicas apropiadas para construir un láser suficientemente potente para alimentar una Estrella de la Muerte? Hoy hay una desconcertante variedad de láseres, dependiendo del material que «lasea» y de la energía que es inyectada en el material (por ejemplo, electricidad, haces intensos de luz, incluso explosiones químicas). Entre ellos:

- Láseres de gas. Entre estos se incluyen los láseres de helio-neón, que son muy comunes y dan un familiar haz rojo. Son alimentados mediante ondas de radio o electricidad. Los láseres de helio-neón son muy débiles. Pero los láseres de dióxido de carbono pueden utilizase para moldear, cortar y soldar en la industria pesada, y pueden crear haces de enorme potencia que son totalmente invisibles.

- Láseres químicos. Estos potentes láseres son alimentados por una reacción química, tal como un chorro ardiente de etileno y trifluoruro de nitrógeno, o NE,. Tales láseres son suficientemente potentes para ser utilizados en aplicaciones militares. Láseres químicos se utilizan en láseres del ejército de Estados Unidos, basados en tierra o en el aire, que pueden producir millones de vatios de potencia y están diseñados para disparar contra misiles de corto alcance en pleno vuelo.

- Láseres de excímero. Estos láseres también están alimentados por reacciones químicas, en las que con frecuencia interviene un gas inerte (por ejemplo, argón, kriptón o xenón) y flúor o cloro. Producen luz ultravioleta y pueden utilizarse para grabar minúsculos transistores en chips en la industria de semiconductores, o para cirugía ocular delicada.

- Láseres de estado sólido. El primer láser operativo construido consistía en un cristal de rubí de zafiro-cromo. Una gran variedad de cristales, junto con tulio y otros elementos químicos, soportará un haz láser. Pueden producir pulsos ultracortos de luz láser de alta energía.

- Láseres de semiconductor. Diodos, que normalmente se utilizan en la industria de semiconductores, pueden producir los haces intensos utilizados en la industria de corte y soldadura. También suelen encontrarse en las cajas registradoras de los supermercados para leer el código de barras de los productos.

- Láseres de colorante. Estos láseres utilizan colorantes orgánicos como medio. Son excepcionalmente útiles para crear pulsos ultracortos de luz, que con frecuencia solo duran billonésimas de segundo.

LÁSERES Y PISTOLAS DE RAYOS

Dada la gran variedad de láseres comerciales y la potencia de los láseres militares, ¿por qué no tenemos pistolas de rayos aptas para usar en combate o en el campo de batalla? Pistolas de rayos de uno u otro tipo parecen ser algo estándar en el armamento de las películas de ciencia ficción. ¿Por qué no estamos trabajando para crearlas? La simple respuesta está en la falta de una batería portátil. Se necesitarían baterías en miniatura que tuvieran la potencia de una enorme central eléctrica y pese a todo sean suficientemente pequeñas para caber en la palma de la mano. Hoy día la única manera de dominar la potencia de una gran central nuclear es construir una. Actualmente el aparato militar más pequeño que puede contener grandes cantidades de energía es una bomba de hidrógeno en miniatura, que podría destruir tanto a quien la lleva como al blanco.

Pistolas láser, de ser posibles serian mas pequeñas, creo…

Hay también un segundo problema: la estabilidad del material del láser. En teoría no hay límite a la energía que se puede concentrar en un láser. El problema es que el material del láser en una pistola de rayos manual no sería estable. Los láseres de cristal, por ejemplo, se sobrecalentarán y agrietarán si se bombea en ellos demasiada energía. Así, para crear un láser extraordinariamente potente, del tipo que pudiera vaporizar un objeto o neutralizar a un enemigo, sería necesario utilizarla potencia de una explosión. En tal caso, la estabilidad del material del láser no es una limitación, puesto que dicho láser solo se utilizaría una vez.

La manipulación de un láser requiere de mucho cuidado.

Debido a los problemas de crear una batería portátil y un material de láser estable, no es posible construir una pistola de rayos manual con la tecnología actual. Las pistolas de rayos son posibles, pero solo si están conectadas por cable a una fuente de alimentación. O quizá con nanotecnología podríamos ser capaces de crear baterías en miniatura que almacenen o generen energía suficiente para crear las intensas ráfagas de energía requeridas en un dispositivo manual. Actualmente, como hemos visto, la nanotecnología es muy primitiva. En el nivel atómico los científicos han sido capaces de crear dispositivos atómicos muy ingeniosos, pero poco prácticos, tales como un ábaco atómico y una guitarra atómica. Pero es concebible que a finales de este siglo o en el próximo la nanotecnología sea capaz de darnos baterías en miniatura que puedan almacenar esas fabulosas cantidades de energía.

Un rayo de luz no puede solidificarse ni detenerse.

Los sables de luz adolecen de un problema similar. Cuando se estrenó la película La guerra de las galaxias en los años setenta y los sables de luz se convirtieron en un juguete de éxito entre los niños, muchos críticos señalaron que tales artefactos nunca podrían hacerse. En primer lugar, es imposible solidificar la luz. La luz viaja siempre a la velocidad de la luz, no puede hacerse sólida. En segundo lugar, un haz luminoso no termina en medio del aire como los sables de luz utilizados en La guerra de las galaxias. Los haces luminosos se prolongan indefinidamente; un sable de luz real llegaría al cielo.

Esquema de un posible sable de luz «normal».

En realidad, hay una manera de construir una especie de sable de luz utilizando plasma, o gas ionizado supercaliente. Pueden hacerse plasmas suficientemente calientes para brillar en la oscuridad y también cortar el acero. Un sable de luz de plasma consistiría en una vara delgada y hueca que sale del mango, como una antena telescópica. Dentro de este tubo se liberarían plasmas calientes que escaparían a través de pequeños agujeros situados regularmente a lo largo de la varilla. A medida que el plasma fluyera desde el mango hasta la varilla, y a través de los agujeros, crearía un tubo largo y brillante de gas supercaliente, suficiente para fundir el acero. Este aparato se suele conocer como una antorcha de plasma.

Lo mas parecido a un sable láser es una antorcha de plasma.

Así pues, es posible crear un dispositivo de alta energía que se parece a un sable de luz. Pero como sucede con las pistolas de rayos, sería necesario crear una batería portátil de alta energía. O bien se necesitarían largos cables que conectaran el sable de luz a una fuente de alimentación, o habría que crear, mediante la nanotecnología, una minúscula fuente de alimentación que pudiera suministrar enormes cantidades de potencia. De modo que aunque hoy es posible crear alguna forma de pistolas de rayos y sables de luz, las armas manuales que se encuentran en las películas de ciencia ficción están más allá de la tecnología actual.

ENERGÍA PARA UNA ESTRELLA DE LA MUERTE

Para crear un cañón láser Estrella de la Muerte que pueda destruir un planeta entero y aterrorizar a una galaxia, tal como el que se describe en La guerra de las galaxias, habría que crear el láser más potente que se haya imaginado jamás. Actualmente algunos de los láseres más potentes en la Tierra se están utilizando para producir temperaturas que solo se encuentran en el centro de las estrellas. En forma de reactores de fusión, algún día podrían dominar la potencia de las estrellas en la Tierra.

Reacción de Fusión.

Las máquinas de fusión tratan de imitar lo que sucede en el espacio exterior cuando se forma una estrella. Una estrella empieza como una enorme bola de gas hidrógeno, hasta que la gravedad comprime el gas y con ello lo calienta; las temperaturas llegan a alcanzar niveles astronómicos. En el interior profundo de un núcleo estelar, por ejemplo, las temperaturas pueden ser entre 50 millones y 100 millones de grados centígrados, suficientes para hacer que los núcleos de hidrógeno choquen unos con otros y formen núcleos de helio; en el proceso se libera una ráfaga de energía. La fusión del hidrógeno en helio, en la que una pequeña cantidad de masa se convierte en energía mediante la famosa ecuación de Einstein E = mc2, es la fuente de energía de las estrellas.

La Estrella de la Muerte y su fuente de poder.

Hoy día los científicos ensayan dos maneras de dominar la fusión en la Tierra. Ambas han resultado ser muchos más difíciles de desarrollar de lo esperado.

Fusión por confinamiento inercial

El primer método se llama «confinamiento inercial». Utiliza los láseres más potentes en la Tierra para crear un pedazo de Sol en el laboratorio. Un láser de estado sólido de neodimio es idóneo para reproducir las temperaturas abrasadoras que solo se encuentran en el corazón de una estrella. Estos sistemas de láser tienen el tamaño de una gran fábrica y contienen una batería de láseres que disparan una serie de haces láser paralelos a través de un largo túnel. Estos haces láser de alta potencia inciden en una serie de pequeños espejos dispuestos alrededor de una esfera; los espejos concentran cuidadosamente los haces láser en una minúscula ampolla rica en hidrógeno (hecha de sustancias tales como deuteruro de litio, el ingrediente activo de una bomba de hidrógeno). La ampolla tiene normalmente el tamaño de una cabeza de alfiler y solo pesa 10 miligramos.

El golpe de luz láser incinera la superficie de la ampolla, lo que hace que la superficie se vaporice y comprima la ampolla. Cuando la ampolla colapsa se crea una onda de choque que llega al corazón de la ampolla y hace subir la temperatura a millones de grados, suficiente para fusionar los núcleos de hidrógeno en helio. Las temperaturas y presiones son tan astronómicas que se satisface el «criterio de Lawson», el mismo criterio que se satisface en las bombas de hidrógeno y en el corazón de las estrellas. (El criterio de Lawson establece que debe alcanzarse un rango específico de temperaturas, densidades y tiempo de confinamiento para desatar el proceso de fusión, sea en una bomba de hidrógeno, una estrella o en un reactor de fusión).

En el proceso de confinamiento inercial se liberan enormes cantidades de energía, y también neutrones. (El deuteruro de litio puede llegar a temperaturas de 100 millones de grados centígrados y una densidad veinte veces mayor que la del plomo). Los neutrones que se emiten desde la ampolla inciden en una capa esférica de material que recubre la cámara, y la capa se calienta. La capa calentada hace hervir agua y el vapor puede utilizarse para impulsar una turbina y producir electricidad.

El problema, no obstante, está en ser capaces de concentrar uniformemente una potencia tan intensa en una minúscula ampolla esférica. El primer intento serio de crear fusión por láser fue el láser Shiva, un sistema láser de veinte haces construido en el Laboratorio Nacional Lawrence Livermore (LLNL) en California, que empezó a operar en 1978. (Shiva es la diosa hindú de múltiples brazos, a los que imita el diseño del sistema láser). La actuación del sistema láser Shiva fue decepcionante, pero fue suficiente para demostrar que la fusión por láser es técnicamente posible. El sistema láser Shiva fue reemplazado más tarde por el láser Nova, con una energía diez veces mayor que la de Shiva. Pero el láser Nova tampoco consiguió una ignición adecuada de las ampollas. En cualquier caso, preparó el camino para la investigación actual en la Instalación Nacional de Ignición (NIF), cuya construcción empezó en 1997 en el LLNL.

Pero ni siquiera la máquina de fusión por láser de la NIF, que contiene los láseres más potentes de la Tierra, puede acercarse de momento al poder devastador de la Estrella de la Muerte de La guerra de las galaxias. Para construir tal aparato debemos buscar en otras fuentes de potencia.

Fusión por confinamiento magnético

El segundo método que los científicos podrían utilizar para alimentar una Estrella de la Muerte se llama «confinamiento magnético», un proceso en el que un plasma caliente de hidrógeno gaseoso está contenido dentro de un campo magnético. De hecho, este método podría proporcionar realmente el prototipo para los primeros reactores de fusión comerciales. Hoy día, el proyecto de fusión más avanzado de este tipo es el Reactor Experimental Termonuclear Internacional (ITER).En 2006 un consorcio de naciones (incluidas la Unión Europea, Estados Unidos, China, Japón, Corea, Rusia y la India) decidió construir el ITER en Cadarache, al sur de Francia. Está diseñado para calentar hidrógeno gaseoso hasta 100 millones de grados centígrados. Podría convertirse en el primer reactor de fusión en la historia que genere más energía que la que consume. Está diseñado para generar 500 megavatios de potencia durante 500 segundos (el récord actual es 16 megavatios de potencia durante 1 segundo).

Logotipo de la ITER

El ITER debería generar su primer plasma para 2016 y estar plenamente operativo en 2022. Con un coste de 12.000 millones de dólares, es el tercer proyecto científico más caro de la historia (después del Proyecto Manhattan y la Estación Espacial Internacional). El ITER se parece a un gran donut, con enormes bobinas enrolladas alrededor de la superficie por cuyo interior circula hidrógeno gaseoso. Las bobinas se enfrían hasta hacerse superconductoras, y entonces se bombea en ellas una enorme cantidad de energía eléctrica, lo que crea un campo magnético que confina el plasma dentro del donut. Cuando este se alimenta con una corriente eléctrica, el gas se calienta hasta temperaturas estelares.

La razón de que los científicos estén tan excitados con el ITER es la perspectiva de crear una fuente de energía barata. El suministro de combustible para los reactores de fusión es agua de mar ordinaria, que es rica en hidrógeno. Sobre el papel al menos, la fusión puede proporcionarnos un suministro de energía inagotable y barato. Entonces, ¿por qué no tenemos ahora reactores de fusión? ¿Por qué se han necesitado tantas décadas para hacer progresos si el proceso de fusión ya era conocido en la década de 1950? El problema reside en la enorme dificultad de comprimir el combustible hidrógeno de un modo uniforme. En las estrellas la gravedad comprime el hidrógeno en una esfera perfecta, de modo que el gas se caliente uniforme y limpiamente. En la fusión por láser de la NIF, los haces concéntricos de luz láser que incineran la superficie de la ampolla deben ser perfectamente uniformes, y es extraordinariamente difícil conseguir esta uniformidad.

En las máquinas de confinamiento magnético, los campos magnéticos tienen polos norte y polos sur; como resultado, comprimir el gas uniformemente en una esfera es extremadamente difícil. Lo mejor que podemos hacer es crear un campo magnético en forma de donut. Pero comprimir el gas es como estrujar un globo. Cada vez que se estruja el globo por un extremo, el aire infla alguna otra parte. Estrujar el globo uniforme y simultáneamente en todas direcciones es un reto difícil. Normalmente el gas caliente se escapa de la botella magnética, toca eventualmente las paredes del reactor y detiene el proceso de fusión. Por eso ha sido tan difícil estrujar el hidrógeno durante más de un segundo. A diferencia de la generación actual de centrales nucleares de fisión, un reactor de fusión no creará grandes cantidades de residuos nucleares. (Cada central de fisión tradicional produce cada año 30 toneladas de residuos nucleares de un nivel extremadamente alto. Por el contrario, el residuo nuclear creado por una máquina de fusión sería básicamente el acero radiactivo que quedaría cuando el reactor fuera finalmente desmantelado).

La fusión no resolverá por completo la crisis energética de la Tierra en un futuro cercano; según el francés Pierre-Gilles de Gennes, premio Nobel de Física, «Decimos que pondremos el Sol en una caja. La idea es bonita. El problema es que no sabemos cómo hacer la caja». Pero si todo va bien, los investigadores tienen esperanzas de que en menos de cuarenta años el ITER pueda allanar el camino para la comercialización de la energía de fusión, energía que puede proporcionar electricidad para nuestros hogares. Algún día, los reactores de fusión aliviarán nuestro problema energético, liberando con seguridad la potencia del Sol sobre la Tierra. Pero ni siquiera los reactores de fusión por confinamiento magnético ofrecerían suficiente energía para alimentar un arma como la Estrella de la Muerte. Para eso necesitaríamos un diseño totalmente nuevo.

LÁSERES DE RAYOS X CON DETONADOR NUCLEAR

Hay otra posibilidad para simular un cañón láser Estrella de la Muerte con la tecnología conocida hoy, y es con una bomba de hidrógeno. Una batería de láseres de rayos X que aproveche y concentre la potencia de las armas nucleares podría generar en teoría suficiente energía para activar un dispositivo que podría incinerar un planeta entero. La fuerza nuclear libera una energía que, para una misma cantidad de material, es unos 100 millones de veces mayor que la liberada en una reacción química. Un trozo de uranio enriquecido no mayor que una pelota de tenis es suficiente para incinerar toda una ciudad y convertirla en una bola de fuego —incluso si solo el 1 por ciento de su masa se ha convertido en energía—. Como ya

se ha dicho, hay varias maneras de inyectar energía en un haz láser. La más potente de todas, con mucho, es utilizar la fuerza liberada por una bomba nuclear.

Los láseres de rayos X tienen un enorme valor científico además de militar. Debido a su longitud de onda muy corta pueden utilizase para sondear distancias atómicas y descifrar la estructura atómica de moléculas complejas, una hazaña que es extraordinariamente difícil utilizando métodos ordinarios. Toda una nueva ventana a las reacciones químicas se abre cuando podemos «mirar» los propios átomos en movimiento y su disposición adecuada dentro de una molécula. Puesto que una bomba de hidrógeno emite una enorme cantidad de energía en el rango de rayos X, los láseres de rayos X también pueden ser alimentados por armas nucleares. La persona más estrechamente vinculada con el láser de rayos X es el físico Edward Teller, padre de la bomba de hidrógeno.

Edward Teller, padre de la bomba de hidrógeno.

De todos es sabido que Teller fue el físico que declaró ante el Congreso en los años cincuenta que Robert Oppenheimer, que había dirigido el Proyecto Manhattan, no era digno de confianza para seguir trabajando en la bomba de hidrógeno debido a sus ideas políticas. El testimonio de Teller llevó a que Oppenheimer cayera en desgracia y se le revocara su credencial de seguridad; muchos físicos destacados nunca perdonaron a Teller lo que hizo. Básicamente, el láser de rayos X de Teller es una pequeña bomba nuclear rodeada de varillas de cobre. La detonación del arma nuclear libera una onda de choque esférica de rayos X intensos. Estos rayos X energéticos atraviesan las varillas de cobre, que actúan como el material del láser y concentran la potencia de los rayos X en haces intensos. Estos haces de rayos X podrían dirigirse luego hacia cabezas nucleares enemigas. Por supuesto, un artefacto semejante solo se podría utilizar una vez, puesto que la detonación nuclear

hace que el láser de rayos X se autodestruya.

El test inicial de un láser de rayos X alimentado nuclearmente fue llamado el test Cabra, y se llevó a cabo en 1983 en un pozo subterráneo. Se detonó una bomba de hidrógeno cuyo diluvio de rayos X incoherentes fue luego concentrado en un haz láser de rayos X coherente.

Al principio el test fue considerado un éxito, y de hecho en 1983 inspiró al presidente Ronald Reagan para anunciar, en un discurso histórico, su intención de construir un escudo defensivo «guerra de las galaxias». Así se puso en marcha un proyecto de muchos miles de millones de dólares, que continúa todavía hoy, para construir una serie de artefactos como el láser de rayos X alimentado nuclearmente para acabar con los misiles balísticos intercontinentales (ICBM) enemigos. (Una investigación posterior demostró que el detector utilizado para realizar las medidas durante el test Cabra quedó destruido; por lo tanto sus medidas no eran fiables).

LA FÍSICA DE UNA ESTRELLA DE LA MUERTE

¿Pueden crearse armas capaces de destruir un planeta entero, como en La guerra de las galaxias? En teoría, la respuesta es sí. Habría varias formas de crearlas. En primer lugar, no hay ningún límite físico a la energía que puede liberar una bomba de hidrógeno. He aquí cómo funciona. (Los detalles precisos de la bomba de hidrógeno son alto secreto e incluso hoy están clasificadas por el Gobierno de Estados Unidos, pero las líneas generales son bien conocidas). Una bomba de hidrógeno se construye en realidad en muchas etapas. Mediante una secuencia adecuada de esas etapas, se puede producir una bomba nuclear de magnitud casi arbitraria.

La primera etapa consiste en una bomba de fisión estándar, que utiliza el poder del uranio 235 para liberar una ráfaga de rayos X, como sucedió en la bomba de Hiroshima. Una fracción de segundo antes de que la onda explosiva de la bomba atómica lo destroce todo, la esfera de rayos X en expansión alcanza a la onda (puesto que viaja a la velocidad de la luz), que es entonces reconcentrada en un contenedor de deuteruro de litio, la sustancia activa de una bomba de hidrógeno.(Cómo se hace esto exactamente sigue siendo materia reservada).

Los rayos X que inciden en el deuteruro de litio hacen que colapse y se caliente hasta millones de grados, lo que provoca una segunda explosión, mucho mayor que la primera. La ráfaga de rayos X procedente de esta bomba de hidrógeno puede luego ser reconcentrada en un segundo trozo de deuteruro de litio, lo que provoca una tercera explosión. De esta manera, se pueden apilar capas de deuteruro de litio y crear una bomba de hidrógeno de magnitud inimaginable.

De hecho, la mayor bomba de hidrógeno construida fue una de dos etapas detonada por la Unión Soviética en 1961, que liberó una energía de 50 millones de toneladas de TNT, aunque teóricamente era capaz de un explosión equivalente a más de 100 millones de toneladas de TNT (unas 5.000 veces la potencia de la bomba de Hiroshima). Incinerar un planeta entero, sin embargo, es algo de una magnitud completamente diferente. Para esto, la Estrella de la Muerte tendría que lanzar miles de tales láseres de rayos X al espacio, y luego sería necesario dispararlos todos a la vez. (Recordemos, por comparación, que en el apogeo de la guerra fría Estados Unidos y la Unión Soviética almacenaban unas 30.000 bombas nucleares cada uno).

La energía total de un número tan enorme de láseres de rayos X sería suficiente para incinerar la superficie de un planeta. Por lo tanto, sería ciertamente posible que un imperio galáctico a cientos de miles de años en el futuro creara un arma semejante. Para una civilización muy avanzada hay una segunda opción: crear una Estrella de la Muerte utilizando la energía de un estallido de rayos gamma. Una Estrella de la Muerte semejante liberaría una ráfaga de radiación solo superada por el big bang. Los estallidos de rayos gamma ocurren de forma natural en el espacio exterior, pero es concebible que una civilización avanzada pudiera dominar su enorme poder. Controlando el giro de una estrella mucho antes de que sufra un colapso y produzca una hipernova, se podría dirigir el estallido de rayos gamma a cualquier punto del espacio.

ESTALLIDOS DE RALLOS GAMMA

Los estallidos de rayos gamma se vieron realmente por primera vez en la década de 1970, cuando el ejército de Estados Unidos lanzó el satélite Vela para detectar «destellos nucleares» (pruebas de una detonación no autorizada de una bomba nuclear). Pero en lugar de detectar destellos nucleares, el satélite Vela detectó enorme ráfagas de radiación procedentes del espacio.

Satélite Vela.

Al principio, el descubrimiento sembró el pánico en el Pentágono: ¿estaban los soviéticos probando una nueva arma nuclear en el espacio exterior? Más tarde se determinó que esas ráfagas de radiación llegaban uniformemente de todas las direcciones del cielo, lo que significaba que en realidad procedían de fuera de la Vía Láctea. Pero si eran extragalácticas, debían estar liberando cantidades de energía verdaderamente astronómicas, suficientes para iluminar todo el universo visible.

Cuando la Unión Soviética se descompuso en 1990, el Pentágono desclasificó un gran volumen de datos astronómicos, lo que abrumó a los astrónomos. De repente, los astrónomos comprendieron que tenían delante un fenómeno nuevo y misterioso, un fenómeno que requeriría reescribir los libros de texto de ciencia. Puesto que los estallidos de rayos gamma duran solo de algunos segundos a unos pocos minutos antes de desaparecer, se requiere un elaborado sistema de sensores para detectarlos y analizarlos. Primero, los satélites detectan la ráfaga de radiación inicial y envían las coordenadas exactas de la ráfaga a la Tierra. Estas coordenadas son entonces introducidas en telescopios ópticos o radiotelescopios, que apuntan hacia la localización exacta del estallido de rayos gamma.

Aunque quedan muchos detalles por clarificar, una teoría sobre los orígenes de los estallidos de rayos gamma es que son «hipernovas» de enorme potencia que dejan tras ellas agujeros negros masivos. Es como si los estallidos de rayos gamma fueran agujeros negros monstruosos en formación. Pero los agujeros negros emiten dos «chorros» de radiación, uno desde el polo norte y otro desde el polo sur, como una peonza que gira. La radiación que se ve procedente de un estallido de rayos gamma distante es, al parecer, uno de los chorros que apunta hacia la Tierra. Si el chorro de un estallido de rayos gamma estuviera dirigido a la Tierra y el estallido de rayos gamma estuviese en nuestra vecindad galáctica (a unos pocos centenares de años luz de la Tierra), su potencia sería suficiente para destruir toda la vida en nuestro planeta.

Inicialmente, el pulso de rayos X del estallido de rayos gamma crearía un pulso electromagnético que barrería todos los equipos electrónicos en la Tierra. Su intenso haz de rayos X y rayos gamma sería suficiente para dañar la atmósfera de la Tierra y destruir nuestra capa de ozono protectora. El chorro del estallido de rayos gamma calentaría la superficie de la Tierra a grandes temperaturas, lo que eventualmente provocaría enormes tormentas que abarcarían todo el planeta. Quizá el estallido de rayos gamma no hiciera explotar en realidad al planeta, como en la película La guerra de las galaxias, pero sin duda destruiría toda la vida, dejando un planeta desolado.

Es concebible que una civilización centenares de miles o un millón de años más avanzada que la nuestra fuera capaz de dirigir un agujero negro semejante en la dirección de un blanco. Esto podría hacerse desviando la trayectoria de planetas y estrellas de neutrones hacia la estrella moribunda a un ángulo preciso antes de que colapse. Esta desviación sería suficiente para cambiar el eje de giro de la estrella de modo que pudiera apuntarse en una dirección dada. Una estrella moribunda sería el mayor cañón de rayos imaginable. Y para los habitantes del planeta objetivo seria el fin, esperemos que a nuestra querida Tierra no le ocurra nada parecido…

[ Esta entrada participa en la XXXIX Edición del Carnaval de la Física, que esta siendo organizado en esta ocasión por el blog El zombi de Schrödinger. ]

REFERENCIAS |

- http://es.wikipedia.org/wiki/L%C3%A1ser

- http://es.wikipedia.org/wiki/Diodo_l%C3%A1ser

- http://es.wikipedia.org/wiki/L%C3%A1ser_de_punto_cu%C3%A1ntico

- http://es.wikipedia.org/wiki/L%C3%A1ser_de_helio-ne%C3%B3n

- http://es.wikipedia.org/wiki/M%C3%A1ser

- http://es.wikipedia.org/wiki/L%C3%A1ser_excimer

- http://www.ciencia-ficcion.com/glosario/f/faser.htm

- http://starwars.wikia.com/wiki/Star_Wars

- http://es.wikipedia.org/wiki/Estrella_de_la_Muerte

- http://www.solarviews.com/cap/sat/mimas2.htm

- http://es.starwars.wikia.com/wiki/Estrella_de_la_Muerte_II

- http://es.starwars.wikia.com/wiki/Estrella_de_la_Muerte_I

- http://es.starwars.wikia.com/wiki/Rayo_Superl%C3%A1ser_de_Parab%C3%B3lica_C%C3%B3ncava

- http://es.wikipedia.org/wiki/Luz

- http://es.wikipedia.org/wiki/Fusi%C3%B3n_nuclear

- http://hyperphysics.phy-astr.gsu.edu/hbase/nucene/nucbin2.html#c1

- http://books.google.com.gt/books/about/F%C3%ADsica_de_lo_imposible.html?id=OFe1gx4gJv4C&redir_esc=y

- http://www.nobelprize.org/nobel_prizes/physics/laureates/1901/rontgen-bio.html

- http://www.xtal.iqfr.csic.es/Cristalografia/parte_02.html

- http://es.wikipedia.org/wiki/Rayos_gamma

- http://partner.cab.inta-csic.es/index.php?Section=Curso_Fundamentos_Capitulo_1

- http://es.wikipedia.org/wiki/Fot%C3%B3n

- http://es.wikipedia.org/wiki/Werner_Heisenberg

- http://www.aip.org/history/gap/Compton/01_Compton.html

- http://links.jstor.org/sici?sici=0036-8075%2819950714%293%3A269%3A5221%3C198%3AOOBCIA%3E2.0.CO%3B2-G

- http://scienceblogs.com/builtonfacts/2009/02/04/the-physics-of-the-death-star/

La Ciencia de la Invisibilidad

Todos, absolutamente todos hemos estado en algún momento de nuestra existencia en situaciones absolutamente bochornosas, es completamente inevitable. Muchos nos hemos tropezado para luego caer estrepitosamente, chocar el auto de nuestros padres, olvidarte del aniversario de tu pareja, llamar «mama» a alguna de tus profesoras (algo traumatico), en fin, un montón de situaciones que nadie quisiera experimentar.

Es probable que dentro de unos años te olvides de lo que hiciste un verano, del cumpleaños de tu hijo o hasta del nombre de tu marido, pero lo que nunca olvidarás son esos momentos embarazosos en los que te hubiera gustado que te tragara la tierra, o por lo menos ser invisible, que nadie te viera y así por lo menos no ser victima de las miradas asesinas de los agraviados y quizás una muerte próxima.

Aunque ser invisible no solamente serviría para escapar de alguna situación «difícil». También, es el sueño de muchos ladrones, científicos locos, supervillanos y un montón mas de desequilibrados mentales.

Aunque seria una gran tentación para cualquier humano el poseer esa capacidad, podría hacer lo quisiera sin que nadie pudiera verlo… Algo que quebrantaría la moralidad de cualquier persona… Pero desde el punto de vista científico, ¿Es posible?

¿Realmente es posible hacernos invisibles o hacer invisible algún objeto?… ¿Existe mas de un método para conseguirlo?… ¿Que utilidades puede traernos la invisibilidad ademas de el uso militar?

Por ejemplo, en la famosa serie Star Trek IV: El viaje a casa, la tripulación del Enterprise se apropia de un crucero de batalla Klingon. A diferencia de las naves espaciales de la Flota Estelar de la Federación, las naves espaciales del imperio Klingon tienen un «dispositivo de ocultación» secreto que las hace invisibles a la luz o el radar, de modo que las naves de Klingon pueden deslizarse sin ser detectadas tras las naves espaciales de la Federación y tenderles emboscadas con impunidad. Este dispositivo de ocultación ha dado al imperio Klingon una ventaja estratégica sobre la Federación de Planetas.

Nave Klingon

Pero, ¿Realmente es posible tal dispositivo? o ¿tan solo es una idea disparatada imposible de realizar? La invisibilidad ha sido siempre una de las maravillas de la ciencia ficción y de lo fantástico, desde las páginas de El hombre invisible al mágico manto de invisibilidad de los libros de Harry Potter, o el anillo en El señor de los anillos (mi preferido).

El Anillo Único – El Señor de los Anillos

Pero durante un siglo al menos, casi todos los físicos han descartado la posibilidad de mantos de invisibilidad o algo que se le parezca, afirmando lisa y llanamente que son imposibles: violan las leyes de la óptica y no se adecuan a ninguna de las propiedades conocidas de la materia.

Pero hoy lo imposible puede hacerse posible. Nuevos avances en metamateriales están obligando a una revisión importante de los libros de texto de óptica. Se han construido en el laboratorio prototipos operativos de tales materiales que han despertado un gran interés en los medios de comunicación, la industria y el ejército al hacer que lo visible se haga invisible.

La invisibilidad a través de la historia

La invisibilidad es quizá una de las ideas más viejas en la mitología antigua. Desde el comienzo de la historia escrita, las personas que se han encontrado solas en una noche procelosa se han sentido aterrorizadas por los espíritus invisibles de los muertos, las almas de los que desaparecieron hace tiempo que acechan en la oscuridad.

El héroe griego Perseo pudo acabar con la malvada Medusa armado con el yelmo de la invisibilidad.

Los generales de los ejércitos han soñado con un dispositivo de invisibilidad. Siendo invisible, uno podría atravesar las líneas enemigas y capturar al enemigo por sorpresa. Los criminales podrían utilizar la invisibilidad para llevar a cabo robos espectaculares.

La invisibilidad desempeñaba un papel central en la teoría de Platón de la ética y la moralidad. En su principal obra filosófica, La República, Platón narra el mito del anillo de Giges. El pobre pero honrado pastor Giges de Lidia entra en una cueva oculta y encuentra una tumba que contiene un cadáver que lleva un anillo de oro. Giges descubre que ese anillo de oro tiene el poder mágico de hacerle invisible. Pronto este pobre pastor queda embriagado con el poder que le da este anillo. Después de introducirse subrepticiamente en el palacio del rey, Giges utiliza su poder para seducir a la reina y, con la ayuda de esta, asesinar al rey y convertirse en el próximo rey de Lidia.

La moraleja que deseaba extraer Platón es que ningún hombre puede resistir la tentación de poder robar y matar a voluntad. Todos los hombres son corruptibles. La moralidad es una construcción social impuesta desde fuera. Un hombre puede aparentar ser moral en público para mantener su reputación de integridad y honestidad, pero una vez que posee el poder de la invisibilidad, el uso de dicho poder sería irresistible.

Platón

(Algunos creen que esta moraleja fue la inspiración para la trilogía de El señor de los anillos de J. R. R. Tolkien, en la que un anillo que garantiza la invisibilidad a quien lo lleva es también una fuente del mal).

La invisibilidad es asimismo un elemento habitual en la ciencia ficción. En la serie Flash Gordon de la década de 1950, Flash se hace invisible para escapar al pelotón de fusilamiento de Ming el Despiadado. En las novelas y las películas de Harry Potter, Harry lleva un manto especial o «mágico» que le permite moverse por el colegio Hogwarts sin ser detectado.

La capa de la invisibilidad de Harry Potter

H.G. Wells dio forma concreta a esta mitología con su clásica novela El hombre invisible, en la que un estudiante de medicina descubre accidentalmente el poder de la cuarta dimensión y se hace invisible. Por desgracia, él utiliza este fantástico poder para su beneficio privado, empieza una oleada de crímenes menores, y al final muere tratando de huir desesperadamente de la policía.

El hombre invisible

Las ecuaciones de Maxwell y el secreto de la luz

Solo con la obra del físico escocés James Clerk Maxwell, uno de los gigantes de la física del siglo XIX, los físicos tuvieron una comprensión firme de las leyes de la óptica. Maxwell era, en cierto sentido, lo contrario de Michael Faraday.

Mientras que Faraday tenía un soberbio instinto experimental pero ninguna educación formal, Maxwell era un maestro de las matemáticas avanzadas. Destacó como estudiante de física matemática en Cambridge, donde Isaac Newton había trabajado dos siglos antes. Newton había inventado el cálculo infinitesimal, que se expresaba en el lenguaje de las «ecuaciones diferenciales», que describen cómo los objetos experimentan cambios infinitesimales en el espacio y el tiempo.

James Clerk Maxwell

El movimiento de las ondas oceánicas, los fluidos, los gases y las balas de cañón podían expresarse en el lenguaje de las ecuaciones diferenciales. Maxwell tenía un objetivo claro: expresar los revolucionarios hallazgos de Faraday y sus campos de fuerza mediante ecuaciones diferenciales precisas.

Maxwell partió del descubrimiento de Faraday de que los campos eléctricos podían convertirse en campos magnéticos, y viceversa. Asumió las representaciones de Faraday de los campos de fuerza y las reescribió en el lenguaje preciso de las ecuaciones diferenciales, lo que dio lugar a uno de los más importantes conjuntos de ecuaciones de la ciencia moderna. constituyen un conjunto de ocho ecuaciones diferenciales de aspecto imponente. Cualquier físico e ingeniero del mundo tiene que jurar sobre ellas cuando llega a dominar el electromagnetismo en la facultad.

A continuación, Maxwell se hizo la pregunta decisiva: si los campos magnéticos pueden convertirse en campos eléctricos y viceversa, ¿qué sucede si se están convirtiendo continuamente unos en otros en una pauta inacabable? Maxwell encontró que estos campos electromagnéticos crearían una onda muy parecida a las olas en el mar. Calculó la velocidad de dichas ondas y, para su asombro, ¡descubrió que era igual a la velocidad de la luz! En 1864, tras descubrir este hecho, escribió proféticamente: «Esta velocidad es tan próxima a la de la luz que parece que tenemos una buena razón para concluir que la propia luz… es una perturbación electromagnética».

Fue quizá uno de los mayores descubrimientos de la historia humana. El secreto de la luz se revelaba por fin. Evidentemente, Maxwell se dio cuenta de que todas las cosas, el brillo del amanecer, el resplandor de la puesta de Sol, los extraordinarios colores del arco iris y el firmamento estrellado podían describirse mediante las ondas que garabateaba en una hoja de papel.

Hoy entendemos que todo el espectro electromagnético —desde el radar a la televisión, la luz infrarroja, la luz ultravioleta, los rayos X, las microondas y los rayos gamma— no es otra cosa que ondas de Maxwell, que a su vez son vibraciones de los campos de fuerza de Faraday. Al comentar la importancia de las ecuaciones de Maxwell, Einstein escribió que son «las más profundas y fructíferas que ha experimentado la física desde la época de Newton».

La teoría de la luz de Maxwell y la teoría atómica dan explicaciones sencillas de la óptica y la invisibilidad. En un sólido, los átomos están fuertemente concentrados, mientras que en un líquido o en un gas las moléculas están mucho más espaciadas. La mayoría de los sólidos son opacos porque los rayos de luz no pueden atravesar la densa matriz de átomos en un sólido, que actúa como un muro de ladrillo. Por el contrario, muchos líquidos y gases son transparentes porque la luz pasa con más facilidad entre los grandes espacios entre sus átomos, un espacio que es mayor que la longitud de onda de la luz visible.

Existen excepciones importantes a esta regla. Muchos cristales son, además de sólidos, transparentes. Pero los átomos de un cristal están dispuestos en una estructura reticular precisa, ordenados en filas regulares, con un espaciado regular entre ellos. Así, un haz luminoso puede seguir muchas trayectorias a través de una red cristalina. Por consiguiente, aunque un cristal está tan fuertemente empaquetado como cualquier sólido, la luz puede abrirse camino a través del cristal.

Bajo ciertas condiciones, un objeto sólido puede hacerse transparente si los átomos se disponen al azar. Esto puede hacerse calentando ciertos materiales a alta temperatura y enfriándolos rápidamente. El vidrio, por ejemplo, es un sólido con muchas propiedades de un líquido debido a la disposición aleatoria de sus átomos. Algunos caramelos también pueden hacerse transparentes con este método. Es evidente que la invisibilidad es una propiedad que surge en el nivel atómico, mediante las ecuaciones de Maxwell, y por ello sería extraordinariamente difícil, si no imposible, de reproducir utilizando métodos ordinarios.

Para hacer invisible a Harry Potter habría que licuarlo, hervirlo para crear vapor, cristalizarlo, calentarlo de nuevo y luego enfriarlo, todo lo cual sería muy difícil de conseguir incluso para un mago.

El ejército, incapaz de crear aviones invisibles, ha intentado hacer lo que más se les parece: crear tecnología furtiva, que hace los aviones invisibles al radar. La tecnología furtiva se basa en las ecuaciones de Maxwell para conseguir una serie de trucos. Un caza a reacción furtivo es perfectamente visible al ojo humano, pero su imagen en la pantalla de un radar enemigo solo tiene el tamaño que correspondería a un pájaro grande. (La tecnología furtiva es en realidad una mezcla de trucos. Cambiando los materiales dentro del caza a reacción, reduciendo su contenido de acero y utilizando en su lugar plásticos y resinas, cambiando los ángulos de su fuselaje, re-ordenando sus toberas, y así sucesivamente, es posible hacer que los haces del radar enemigo que inciden en el aparato se dispersen en todas direcciones, de modo que nunca vuelven a la pantalla del radar enemigo.

Caza furtivo moderno F-35 Lightning II

Incluso con tecnología furtiva, un caza a reacción no es del todo invisible; lo que hace es desviar y dispersar tantas ondas de radar como es técnicamente posible).

Metamateriales e invisibilidad

Pero quizá el más prometedor entre los nuevos desarrollos que implican invisibilidad es un nuevo material exótico llamado «metamaterial», que tal vez un día haga los objetos verdaderamente invisibles. Resulta irónico que la creación de metamateriales se considerara en otro tiempo imposible porque violaban las leyes de la óptica. Pero en 2006, investigadores de la Universidad de Duke en Durham, Carolina del Norte, y del Imperial College de Londres, desafiaron con éxito la sabiduría convencional y utilizaron metamateriales para hacer un objeto invisible a la radiación de microondas. Aunque hay aún muchos obstáculos que superar, ahora tenemos por primera vez en la historia un diseño para hacer invisibles objetos ordinarios. (La Agencia de Investigación de Proyectos Avanzados de Defensa [DARPA] del Pentágono financió esta investigación).

El potencial revolucionario de los metamateriales «cambiará por completo nuestro enfoque de la óptica y casi todos los aspectos de la electrónica. Algunos de estos metamateriales pueden hacer realidad hazañas que habrían parecido milagrosas hace solo unas décadas».

¿Qué son estos metamateriales? Son sustancias que tienen propiedades ópticas que no se encuentran en la naturaleza. Los metamateriales se crean insertando en una sustancia minúsculos implantes que obligan a las ondas electromagnéticas a, curvarse de formas heterodoxas. En la Universidad,de Duke los científicos insertaron en bandas,de cobre minúsculos circuitos eléctricos dispuestos,en círculos planos concéntricos (una forma,que recuerda algo a las resistencias de un horno,eléctrico).

Ejemplo de lo que seria un auto construido con metamateriales.

El resultado fue una mezcla sofisticada,de cerámica, teflón, compuestos de fibra y componentes,metálicos. Estos minúsculos implantes,en el cobre hacen posible curvar y canalizar de,una forma específica la trayectoria de la radiación,de microondas. Pensemos en cómo fluye un río alrededor de una roca. Puesto que el agua rodea fácilmente la roca, la presencia de la roca no se deja sentir aguas abajo. Del mismo modo, los metamateriales pueden alterar y curvar continuamente la trayectoria de las microondas de manera que estas fluyan alrededor de un cilindro, por ejemplo, lo que haría esencialmente invisible a las microondas todo lo que hay dentro del cilindro.

Si el material puede eliminar toda la reflexión y todas las sombras, entonces puede hacer un objeto totalmente invisible para dicha forma de, radiación. Los científicos demostraron satisfactoriamente,este principio con un aparato hecho de diez anillos,de fibra óptica cubiertos con elementos de,cobre. Un anillo de cobre en el interior del aparato,se hacía casi invisible a la radiación de microondas,pues solo arrojaba una sombra, minúscula.

En el corazón de los metamateriales está su capacidad para manipular algo llamado «índice de refracción ». La refracción es la curvatura que experimenta la trayectoria de la luz cuando atraviesa un medio transparente. Si usted mete la mano en el agua, o mira a través de los cristales de sus gafas, advertirá que el agua y el cristal distorsionan y curvan la trayectoria de la luz ordinaria.

Manipulación de la Refracción por parte de un Metamaterial.

La razón de que la luz se curve en el cristal o en el agua es que la luz se frena cuando entra en un medio transparente denso. La velocidad de la luz en el vacío es siempre la misma, pero la luz que viaja a través del agua o del cristal debe atravesar billones de átomos y con ello se frena. (El cociente entre la velocidad de la luz en el vacío y la velocidad más lenta de la luz entro de un medio es lo que se llama índice de refracción. Puesto que la luz se frena en el vidrio, el índice de refracción de este es siempre mayor que 1,0).

Por ejemplo, el índice de refracción es 1,0 para el vacío, 1,0003 para el aire, 1,5 para el vidrio y 2,4 para el diamante. Normalmente, cuanto más denso es el medio, mayor es el grado de curvatura, y mayor el índice de refracción. Un efecto familiar del índice de refracción es un espejismo. Si usted viaja en coche un día tórrido y mira hacia delante al horizonte, verá cómo la carretera parece brillar y crea la ilusión de un lago donde se refleja la luz.

Un ejemplo de Espejismo en el Desierto.

En el desierto pueden verse a veces las siluetas de ciudades y montañas distantes en el horizonte. Esto se debe a que el aire caliente que sube del asfalto o del suelo del desierto tiene una densidad menor que el aire normal, y por lo tanto un índice de refracción menor que el del aire más frío que le rodea; por ello, la luz procedente de objetos distantes puede refractarse en el asfalto hacia sus ojos y producirle la ilusión de que está viendo objetos distantes.

Normalmente, el índice de refracción es constante. Un fino haz de luz se curva cuando entra en el vidrio y luego sigue una línea recta. Pero supongamos por un momento que pudiéramos controlar el índice de refracción a voluntad, de modo que pudiera cambiar de forma continua en cada punto del vidrio. A medida que la luz se moviera en este nuevo material, se iría curvando y alabeando en nuevas direcciones, en una trayectoria que serpentearía a través de la sustancia.

Si pudiéramos controlar el índice de refracción dentro de un metamaterial de modo que la luz rodeara a un objeto, entonces el objeto se haría invisible. Para ello, este metamaterial debería tener un índice de refracción negativo, lo que cualquier libro de texto de óptica dice que es imposible.

Concepto de Refracción.

(Los metamateriales fueron teorizados por primera vez en un artículo del físico soviético Víctor Veselago en 1967, y se demostró que tenían propiedades ópticas extrañas, tales como un índice de refracción negativo y efecto Doppler inverso. Los metamateriales son tan extraños y aparentemente absurdos que en otro tiempo se pensó que eran imposibles de construir. Pero en los últimos años se han construido metamateriales en el laboratorio, lo que ha obligado a los físicos reacios a reescribir los libros de texto de óptica).

Aunque un verdadero manto de invisibilidad es posible dentro de las leyes de la física, como reconocerán la mayoría de los físicos, aún quedan formidables obstáculos técnicos antes de que esta tecnología pueda extenderse para trabajar con luz visible y no solo radiación de microondas.

En general, las estructuras internas implantadas dentro del metamaterial deben ser más pequeñas que la longitud de onda de la radiación. Por ejemplo, las microondas pueden tener una longitud de onda de unos 3 centímetros, de modo que para que un metamaterial curve la trayectoria de las microondas debe tener insertados en su interior implantes minúsculos menores que 3 centímetros. Pero para hacer un objeto invisible a la luz verde, con una longitud de onda de 500 nanómetros (nm), el metamaterial debe tener insertadas estructuras que sean solo de unos 50 nanómetros de longitud, y estas son escalas de longitud atómica que requieren nanotecnología.

Escala de los Nanómetros y Micrómetros.

(Un nanómetro es una mil millonésima de metro. Aproximadamente cinco átomos pueden caber en un nanómetro). Este es quizá el problema clave al que se enfrentan nuestros intentos de crear un verdadero manto de invisibilidad. Los átomos individuales dentro de un metamaterial tendrían que ser modificados para curvar un rayo de luz como una serpiente.

Metamateriales para luz visible

La carrera ha empezado. Desde que se anunció que se han fabricado materiales en el laboratorio se ha producido una estampida de actividad en esta área, con nuevas ideas y sorprendentes avances cada pocos meses. El objetivo es claro: utilizar nanotecnología para crear metamateriales que puedan curvar la luz visible, no solo las microondas. Se han propuesto varios enfoques, todos ellos muy prometedores. Uno de ellos es utilizar la tecnología ya disponible, es decir, tomar prestadas técnicas ya conocidas de la industria de semiconductores para crear nuevos metamateriales. Una técnica llamada «fotolitografía » está en el corazón de la miniaturización informática, y con ello impulsa la revolución de los ordenadores. Esta tecnología permite a los ingenieros colocar cientos de millones de minúsculos transistores en una pastilla de silicio no mayor que un pulgar.

La razón de que la potencia de los ordenadores se duplique cada dieciocho meses (lo que se conoce como ley de Moore) es que los científicos utilizan luz ultravioleta para «grabar» componentes cada vez más pequeños en un chip de silicio. Esta técnica es muy similar al modo en que se utilizan las plantillas para crear vistosas camisetas. (Los ingenieros de ordenadores empiezan con una delgada tableta de silicio y aplican sobre ella capas extraordinariamente delgadas de materiales diversos. Luego se coloca sobre la tableta una máscara plástica que actúa como una plantilla. Esta contiene los complejos perfiles de los cables, transistores y componentes de ordenador que constituyen el esqueleto básico del circuito. La tableta se baña entonces en radiación ultravioleta, que tiene una longitud de onda muy corta, y dicha radiación imprime la estructura en la tableta fotosensible. Tratando la tableta con gases y ácidos especiales, la circuitería completa de la máscara queda grabada en las zonas de la tableta que estuvieron expuestas a la luz ultravioleta. Este proceso crea una tableta que contiene centenares de millones de surcos minúsculos, que forman los perfiles de los transistores).

Un spinner utilizado en la fotolitografía.

Actualmente, los componentes más pequeños que se pueden crear con este proceso de grabado son de unos 53 nm (o unos 150 átomos de largo). Un hito en la búsqueda de la invisibilidad se alcanzó cuando esta técnica de grabado de tabletas fue utilizada por un grupo de científicos para crear el primer metamaterial que opera en el rango de la luz visible. Científicos en Alemania y en el Departamento de Energía de Estados Unidos anunciaron a principios de 2007 que, por primera vez en la historia, habían fabricado un metamaterial que funcionaba para luz roja. Lo «imposible» se había conseguido en un tiempo notablemente corto. El físico Costas Soukoulis del Laboratorio Ames en Iowa, junto con Stefan Linden, Martin Wegener y Gunnar Dolling de la Universidad de Karlsruhe, en Alemania, fueron capaces de crear un metamaterial que tenía un índice de —0,6 para la luz roja, con una longitud de onda de 780 nm.

Hasta ahora esos científicos han conseguido un índice de refracción negativo solo para luz roja. Su próximo paso sería utilizar esta tecnología para crear un metamaterial que curvara la luz roja enteramente alrededor de un objeto, haciéndolo invisible a dicha luz. Estas líneas de investigación pueden tener desarrollos futuros en el área de los «cristales fotónicos». El objetivo de la tecnología de cristales fotónicos es crear un chip que utilice luz, en lugar de electricidad, para procesar información.

Esto supone utilizar nanotecnología para grabar minúsculos componentes en una tableta, de modo que el índice de refracción cambie con cada componente. Los transistores que utilizan luz tienen varias ventajas sobre los que utilizan electricidad. Por ejemplo, las pérdidas de calor son mucho menores en los cristales fotónicos. (En los chips de silicio avanzados, el calor generado es suficiente para freír un huevo. Por ello deben ser enfriados continuamente o de lo contrario fallarán, pero mantenerlos fríos es muy costoso).

No es sorprendente que la ciencia de los cristales fotónicos sea ideal para los metamateriales, puesto que ambas tecnologías implican la manipulación del índice de refracción de la luz en la nanoescala.

La Invisibilidad plasmónica

Para no quedarse atrás, otro grupo anunció a mediados de 2007 que había creado un metamaterial que curva luz visible utilizando una tecnología completamente diferente, llamada «plasmónica». Los físicos Henri Lezec, Jennifer Dionne y Harry Atwater del Instituto de Tecnología de California (Caltech) anunciaron que habían creado un metamaterial que tenía un índice negativo para la más difícil región azul-verde del espectro visible de la luz.

El objetivo de la plasmónica es «estrujar» la luz de modo que se puedan manipular objetos en la nanoescala, especialmente en la superficie de metales. La razón de que los metales conduzcan la electricidad es que los electrones están débilmente ligados a los átomos del metal, de modo que pueden moverse con libertad a lo largo de la superficie de la red metálica. La electricidad que fluye por los cables de su casa representa el flujo uniforme de estos electrones débilmente ligados en la superficie metálica. Pero en ciertas condiciones, cuando un haz luminoso incide en la superficie metálica, los electrones pueden vibrar al unísono con el haz luminoso original, lo que da lugar a movimientos ondulatorios de los electrones en la superficie metálica (llamados plasmones), y estos movimientos ondulatorios laten al unísono con el haz luminoso original.

En física, un plasmón es un cuanto de oscilación del plasma.

Y lo que es más importante, estos plasmones se pueden «estrujar» de modo que tengan la misma frecuencia que el haz original (y con ello lleven la misma información) pero tengan una longitud de onda mucho más pequeña. En principio se podrían introducir estas ondas estrujadas en nanocables.

Como sucede con los cristales fotónicos, el objetivo último de la plasmónica es crear chips de ordenador que computen utilizando luz en lugar de electricidad. El grupo del Caltech construyó su metamaterial a partir de dos capas de plata, con un aislante de silicio-nitrógeno en medio (de un espesor de solo 50 nm), que actuaba como una «guía de onda» que podía guiar la dirección de las ondas plasmónicas.

Luz láser entra y sale del aparato a través de dos rendijas horadadas en el metamaterial. Analizando los ángulos a los que se curva la luz láser cuando atraviesa el metamaterial, se puede verificar que la luz está siendo curvada mediante un índice negativo.

El futuro de los metamateriales

Los avances en metamateriales se acelerarán en el futuro por la sencilla razón de que ya hay un gran interés en crear transistores que utilicen haces luminosos en lugar de electricidad. Por consiguiente, la investigación en invisibilidad puede «subirse al carro» de la investigación en curso en cristales fotónicos y plasmónica para crear sustitutos para el chip de silicio. Ya se están invirtiendo centenares de millones de dólares a fin de crear sustitutos para la tecnología del silicio, y la investigación en metamateriales se beneficiará de estos esfuerzos de investigación. Debido a los grandes avances que se dan en este campo cada pocos meses, no es sorprendente que algunos físicos piensen que algún tipo de escudo de invisibilidad puede salir de los laboratorios en unas pocas décadas.

Por ejemplo, los científicos confían en que en los próximos años serán capaces de crear metamateriales que puedan hacer a un objeto totalmente invisible para una frecuencia de luz visible, al menos en dos dimensiones. Hacer esto requerirá insertar minúsculos nanoimplantes ya no en una formación regular, sino en pautas sofisticadas, de modo que la luz se curve suavemente alrededor de un objeto.

Curvatura de la luz sobre un objeto.

A continuación, los científicos tendrán que crear metamateriales que puedan curvar la luz en tres dimensiones, no solo en las superficies bidimensionales planas. La fotolitografía ha sido perfeccionada para hacer tabletas de silicio planas, pero crear metamateriales tridimensionales requerirá apilar tabletas de una forma complicada.

Después de eso, los científicos tendrán que resolver el problema de crear metamateriales que puedan curvar no solo una frecuencia, sino muchas. Esta será quizá la tarea más difícil, puesto que los minúsculos implantes que se han ideado hasta ahora solo curvan luz de una frecuencia precisa. Los científicos tal vez tendrán que crear metamateriales basados en capas, y cada capa curvará una frecuencia específica. La solución a este problema no está clara. En cualquier caso, una vez que se obtenga finalmente un escudo de invisibilidad, será probablemente un aparato complicado. El manto de Harry Potter estaba hecho de tela delgada y flexible, y volvía invisible a cualquiera que se metiese dentro.

Pero para que esto sea posible, el índice de refracción dentro de la tela tendría que estar cambiando constantemente de forma complicada mientras la tela se agitara, lo que no resulta práctico.

Lo más probable es que un verdadero «manto» de invisibilidad tenga que estar hecho de un cilindro sólido de metamateriales, al menos inicialmente. De esa manera, el índice de refracción podría fijarse dentro del cilindro. (Versiones más avanzadas podrían incorporar con el tiempo metamateriales que sean flexibles y puedan retorcerse, y aun así hacer que la luz fluya en la trayectoria correcta dentro de los metamateriales. De esta manera, cualquiera que estuviera en el interior del manto tendría cierta flexibilidad de movimientos).

Algunos han señalado un defecto en el escudo de invisibilidad: cualquiera que estuviese dentro no sería capaz de mirar hacia fuera sin hacerse visible.

Imaginemos a un Harry Potter totalmente invisible excepto por sus ojos, que parecerían estar flotando en el aire. Cualquier agujero para los ojos en el manto de invisibilidad sería claramente visible desde el exterior. Si Harry Potter fuera invisible se encontraría ciego bajo su manto de invisibilidad. (Una posible solución a este problema sería insertar dos minúsculas placas de vidrio cerca de la posición de los agujeros para los ojos. Estas placas de vidrio actuarían como «divisores de haz», que dividen una minúscula porción de la luz que incide en las placas y luego envía a luz a los ojos. De este modo, la mayor parte de la luz que incidiera en el manto fluiría a su alrededor, haciendo a la persona invisible, pero una minúscula cantidad de luz sería desviada hacia los ojos).

Por terribles que sean estas dificultadas, científicos e ingenieros son optimistas en que algún tipo de manto de invisibilidad pueda construirse en las próximas décadas.

Invisibilidad y nanotecnología

Como he mencionado antes, la clave para la invisibilidad puede estar en la nanotecnología, es decir, la capacidad de manipular estructuras de tamaño atómico de una mil millonésima de metro.

El nacimiento de la nanotecnología data de una famosa conferencia de 1959 impartida por el premio Nobel Richard Feynman ante la Sociedad Americana de Física, con el irónico título «Hay mucho sitio al fondo». En dicha conferencia especulaba sobre lo que podrían parecer las máquinas más pequeñas compatibles con las leyes de la física conocidas. Feynman era consciente de que podían construirse máquinas cada vez más pequeñas hasta llegar a distancias atómicas, y entonces podrían utilizarse los átomos para crear otras máquinas.

Richard Feynman.

Máquinas atómicas, tales como poleas, palancas y ruedas, estaban dentro de las leyes de la física, concluía él, aunque serían extraordinariamente difíciles de hacer.